微软研发MR+机器人框架

基于HoloLens实现机器人操控交互

在过去的数十年间,工程师不断为我们带来功能和性能越来越先进的技术,比方说“空间计算”。

空间计算是指计算机、机器人和其他电子设备“感知”周围环境并创建其数字表示的能力,而混合现实等尖端技术可以显著增强空间计算,并帮助创建复杂的传感和测绘系统。

日前,微软混合现实与人工智能实验室(Microsoft Mixed Reality and AI Lab)和苏黎世理工学院的研究人员提出了一种将混合现实和机器人技术结合起来,以增强空间计算应用的框架。

能够感知周围环境并以数字方式表示的空间计算为人机交互提供了全新的能力。特别是,在混合现实设备结合空间计算和Egocentric Sensing自我中心感知可允许系统捕获和理解人类行为,并将其转化为具有空间意义的行为。

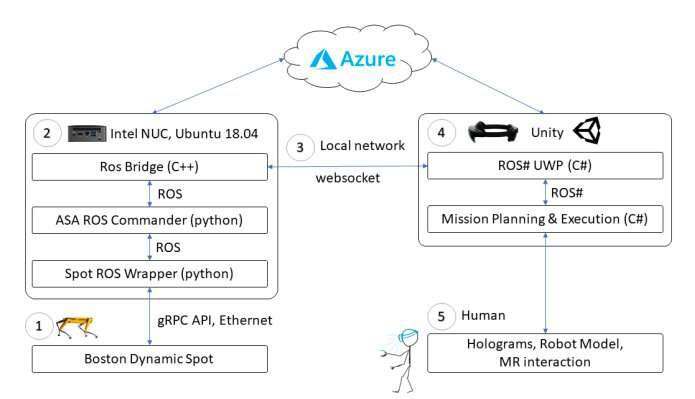

所以在名为《Spatial Computing and Intuitive Interaction: Bringing Mixed Reality and Robotics Together》的论文中,团队提出了基于上述理念的三个机器人用例系统:检查任务规划;基于手势的控制;以及沉浸式远程操作。

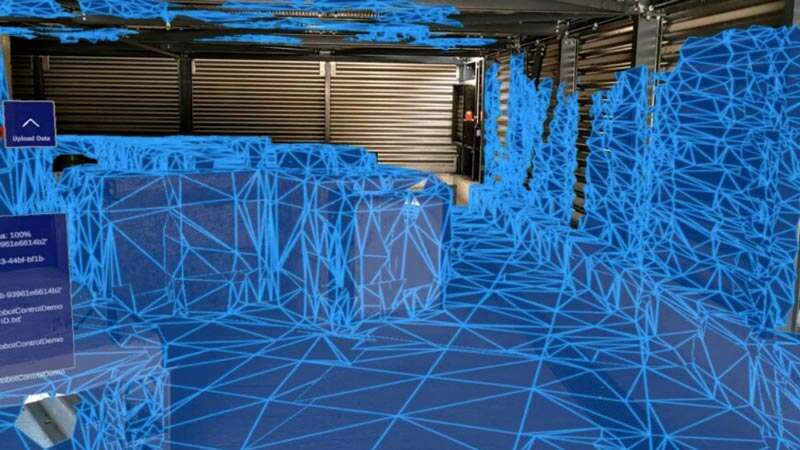

第一个系统设计用于规划需要检查给定环境的机器人任务。基本上,人类用户穿戴HoloLens在目标环境中移动,放置全息图,形成定义机器人轨迹的航路点。另外,用户可以突出显示希望机器人收集图像或数据的特定区域。相关信息经过整理后,就可以在机器人检查环境时用以指导它的动作和行动。

团队创建的第一个系统将HoloLens映射转换为二维占用网格表示,坐标框架与网格对齐,以便通过激光雷达实现机器人定位。

第二个系统是一个基于手势的控制界面。其中,人类用户可以通过HoloLens来有效地与机器人交互,使用手势来操作机器人完成一系列的动作。研究人员指出,设备的共同定位允许它们各自能够将自己定位到一个共同的参考坐标系。基于它们相对于所述公共坐标系的单独姿势,可以计算本地化设备之间的相对变换,并随后用于实现设备之间的新行为和协作。

为了实现设备的共定位,团队引入了一个旨在确保系统中的所有设备都共享彼此位置和一个公共参考映射的映射。用户只需执行一系列直观的手势,就可以使用HoloLens头显为机器人提供导航指示。

第三个系统主要用于沉浸式远程操作,这意味着用户可以在利用机器人的“眼睛”来查看感知机器人周围环境,并且远程控制机器人。对于这个系统,原理与上述介绍类似,远程机器人可以将摄像头视图传送回HoloLens,并在设备用户的视场投射相关的视图。这时,HoloLens可以将用户的操作指令发回给机器人,并致使其执行一系列的操作。

对于需要机器人在人类无法进入的环境中导航的情景,这种系统将特别具有价值。

研究人员解释道:“我们探索用户动作向远程机器人的投射,以及机器人空间感知向用户的投射。我们考虑了多个层次的沉浸感,基于触控和操纵实际机器人的模型来视线控制,以及更高级别的沉浸,亦即将用户的运动直接映射到机器人,令用户‘变成’机器人。”

在最初的测试中,所述三个系统都取得了非常具有前景的实验结果。当然,团队坦诚未来依然需要进一步的优化和测试。但这项实验突出了通过MR+机器人来增强空间计算和人机交互的潜力。未来,所述系统可以应用到众多不同的环境,帮助人类与机器人进行密切协作,从而有效地解决更广泛的复杂现实问题。

相关论文:Spatial Computing and Intuitive Interaction: Bringing Mixed Reality and Robotics Together

团队最后表示:“所述研究展示了混合现实作为人机交互工具的力量,以及空间计算和混合现实推动人机交互未来的潜力。”